夏邑来自奥菲寺。

量子比特制作|微信官方账号QbitAI

公元2019年伊始,深度学习技术也处于一个新的“开端”,值得回顾和展望。

麻省理工学院正在进行的深入研究课程全面描绘了当前的状态。

在最近的一堂课上,Lex Fridman老师展示了深度学习各个方向的领先地位,也回顾了近两年来一步步向前沿迈进的历程。它涉及自然语言处理、深度强化学习、加速训练和推理等等。

这里的“领先”只讲思路方向,不讲标杆跑分。

面对班上表现出的巨大进步,有网友甚至表示:

上课前喝一杯?机器学习进步如此之大,值得一两瓶。

上课前喝一杯?机器学习进步如此之大,值得一两瓶。

视频发布一天多了,感谢不胜枚举。

量子比特课结束后,我用PPT写了一篇笔记,分享给大家。

在我们开始之前,让我们有一个小目录。

本课程涉及12个主要发展,即:

BERT和自然语言处理(NLP) Tesla Autopilot II(上图)硬件:大规模神经网络AdaNet:具有集成学习的AutoMLAutoAugment:用于数据增强的强化学习、用于深度神经网络的合成数据训练、用于图像分割和自动标注的多边形DAWNBench:寻找快速廉价的训练方法BigGAN:最先进的第一、图像合成研究视频到视频合成语义分割AlphaZero和OpenAI五个深度学习框架。我们将逐一阐述。

伯特和NLP

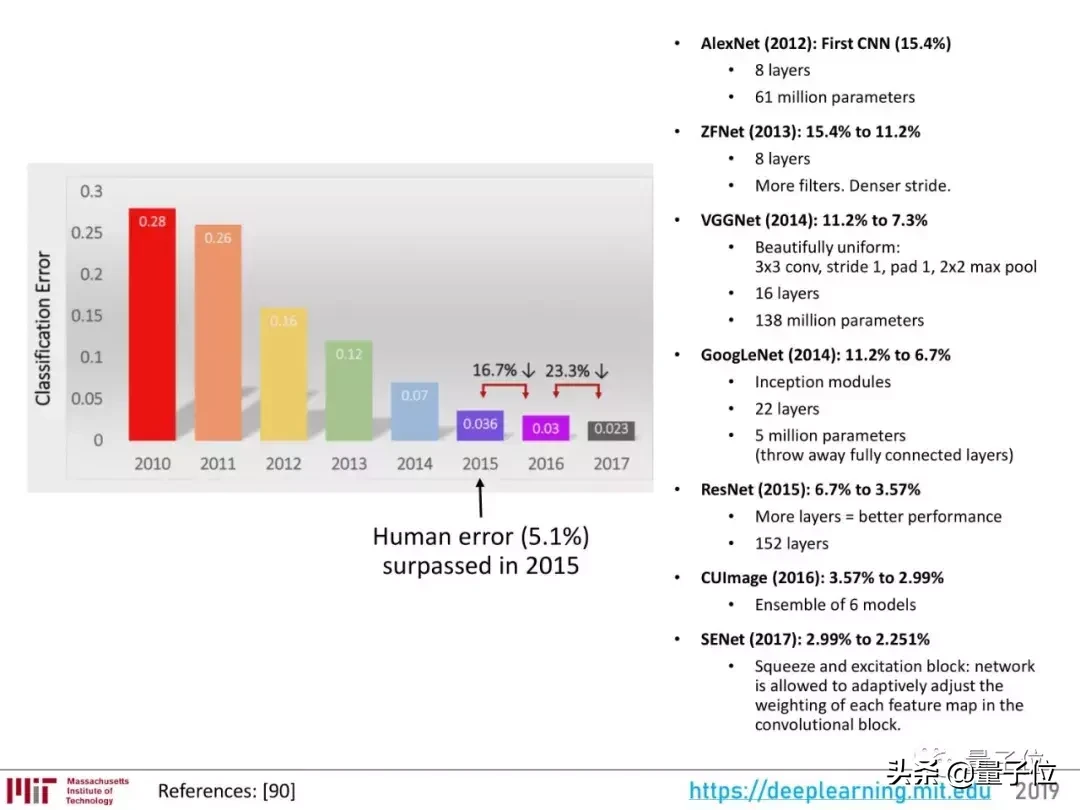

2018年是自然语言处理年。许多业内人士将2012年称为深度学习的ImageNet时刻,因为这一年,AlexNet带来了计算机视觉领域的性能飞跃,激励人们探索深度学习在该领域的更多可能性。

2016年到2018年,NLP的发展也差不多,尤其是BERT的出现。

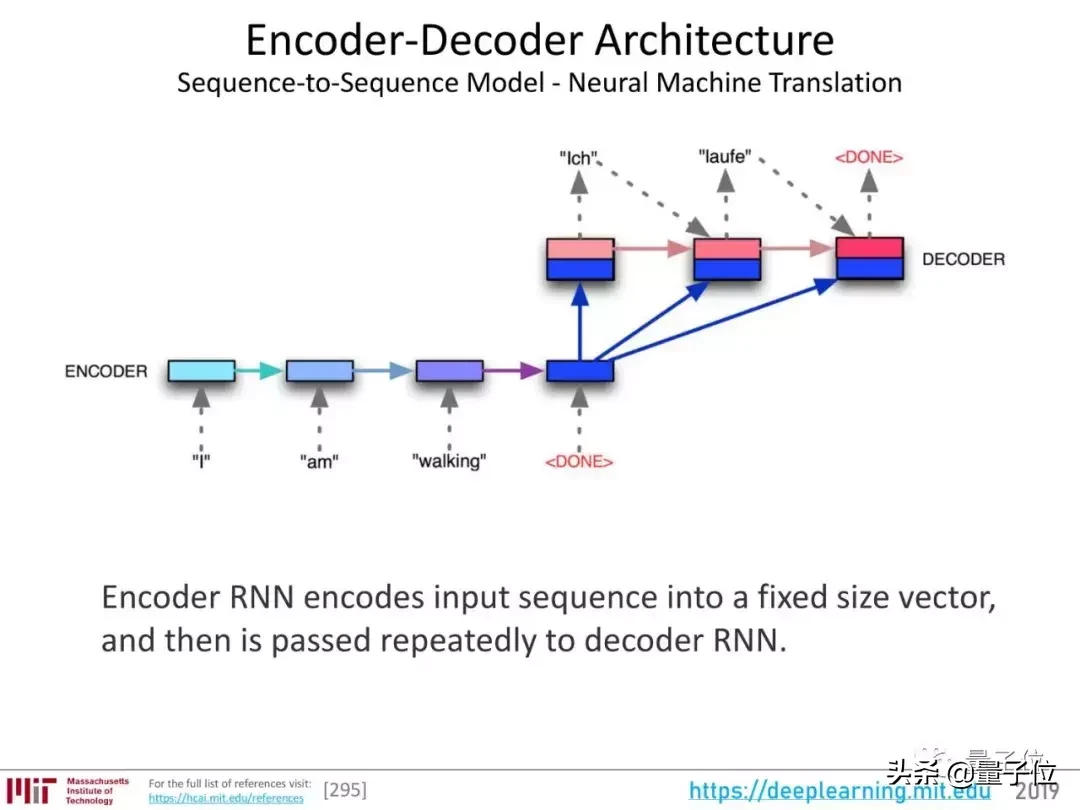

NLP的开发应该从编码器-解码器架构开始。

上图显示了神经机器翻译的序列对序列(seq2seq)模型。RN编码器负责将输入序列编码成固定大小的向量,即整句的“表示”,然后将这个表示传递给RNN解码器。

这种架构在机器翻译等领域非常有用。

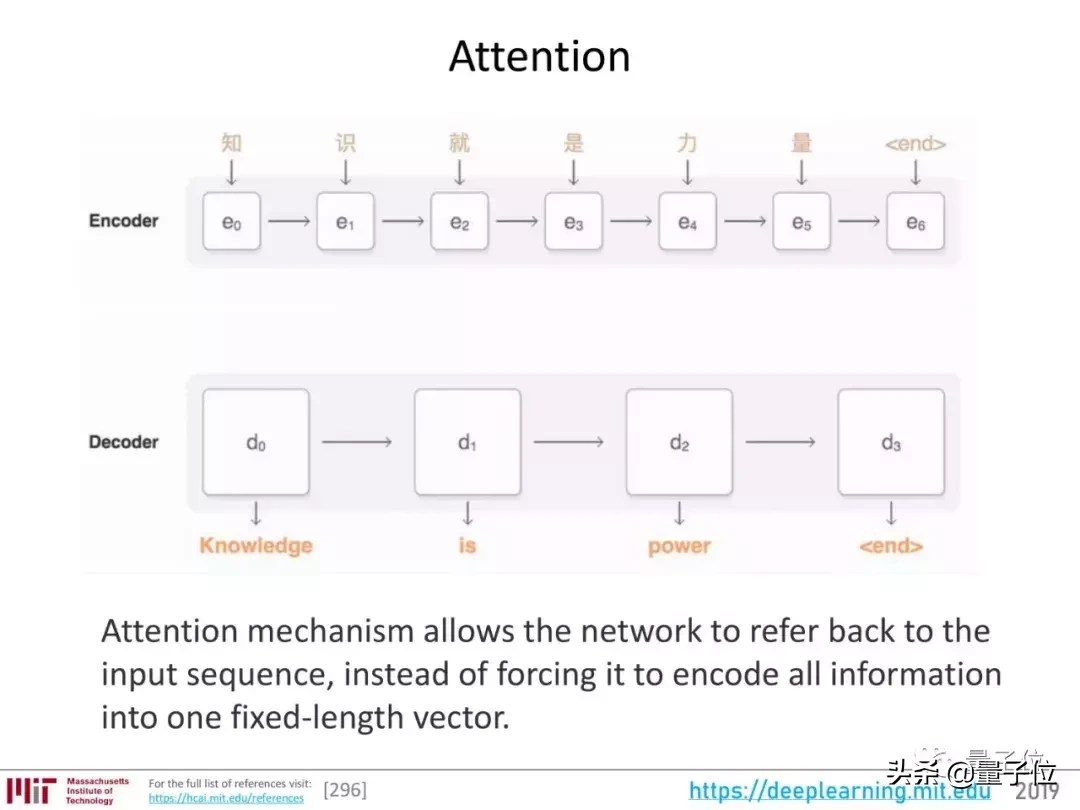

然后注意力的发展。这种机制并不强制网络将所有输入信息编码成一个定长向量,并且可以在解码过程中重新引入输入序列,学习输入序列和输出序列的哪一部分是相互关联的。

更直观的动态显示是这样的:

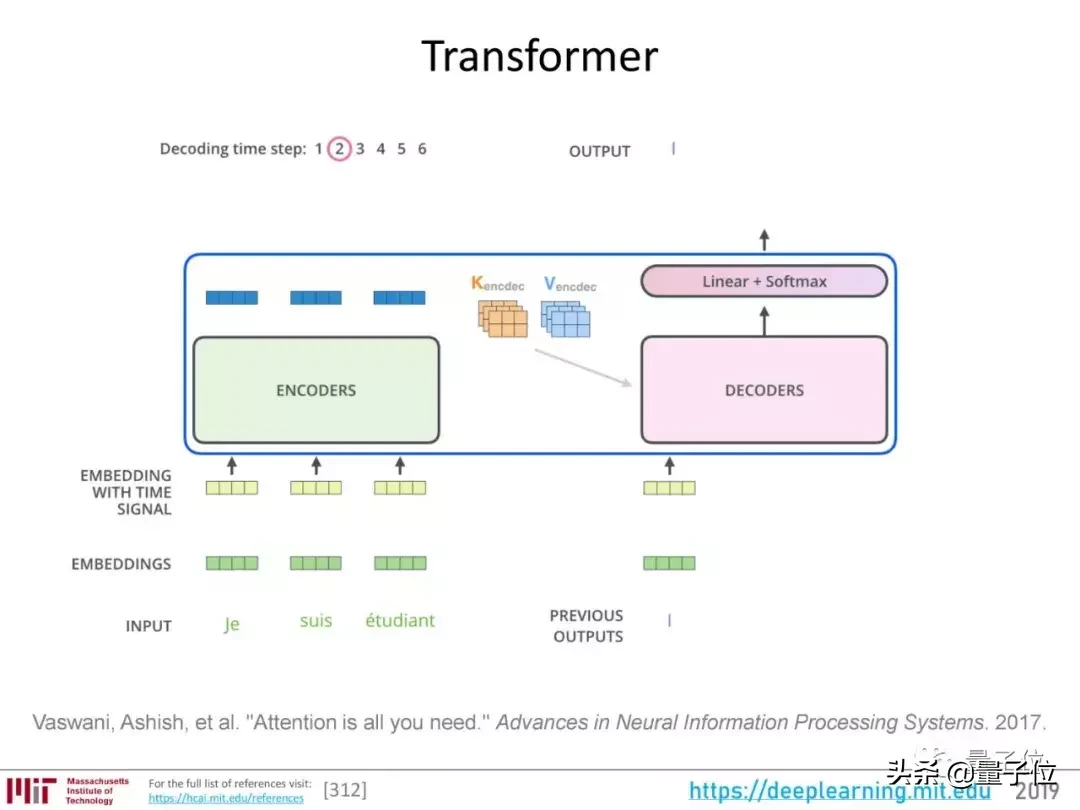

进一步发展到自我关注,谷歌《关注就是你所需要的全部》论文提出的Transformer架构。

Transformer架构的编码器使用自注意机制为输入序列生成一组表示,解码过程也使用注意机制。

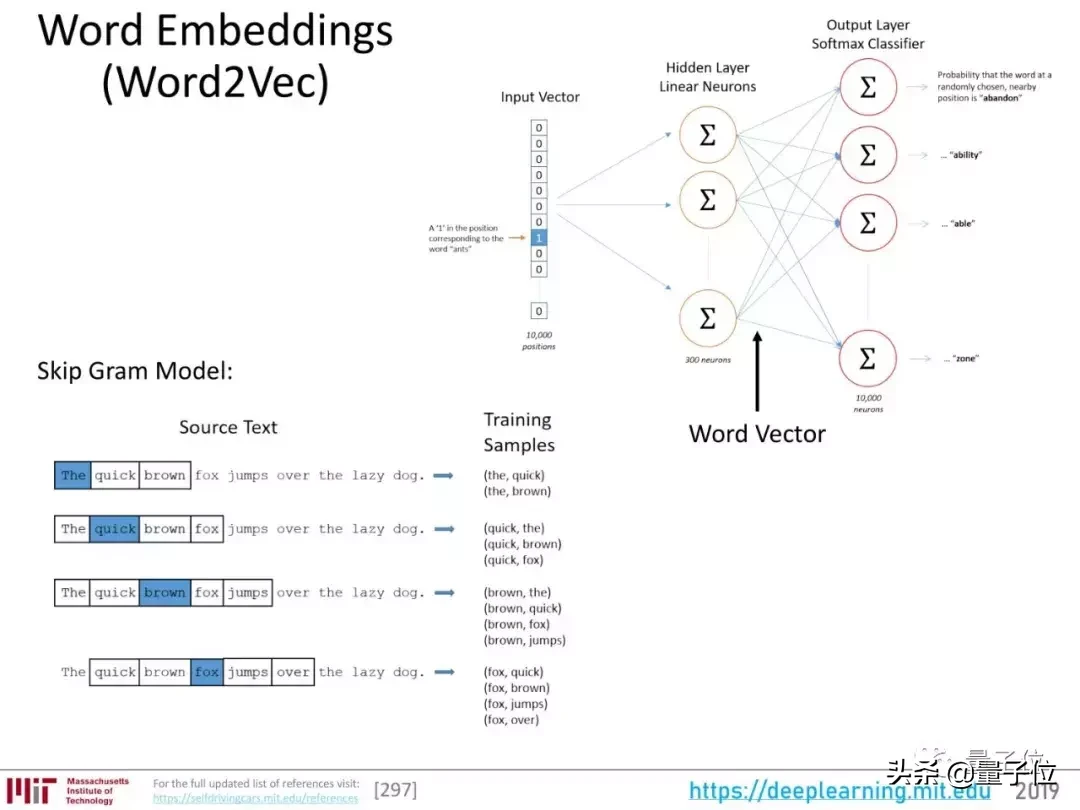

说完了注意力的发展,我们再来看NLP的一个关键基础:单词嵌入。

单词嵌入的过程就是把组成一个句子的单词表达成向量。传统的单词嵌入过程以无监督的方式将单词映射到抽象表示中,单词的表示引用其背后的序列。

这是一个语言建模的过程。

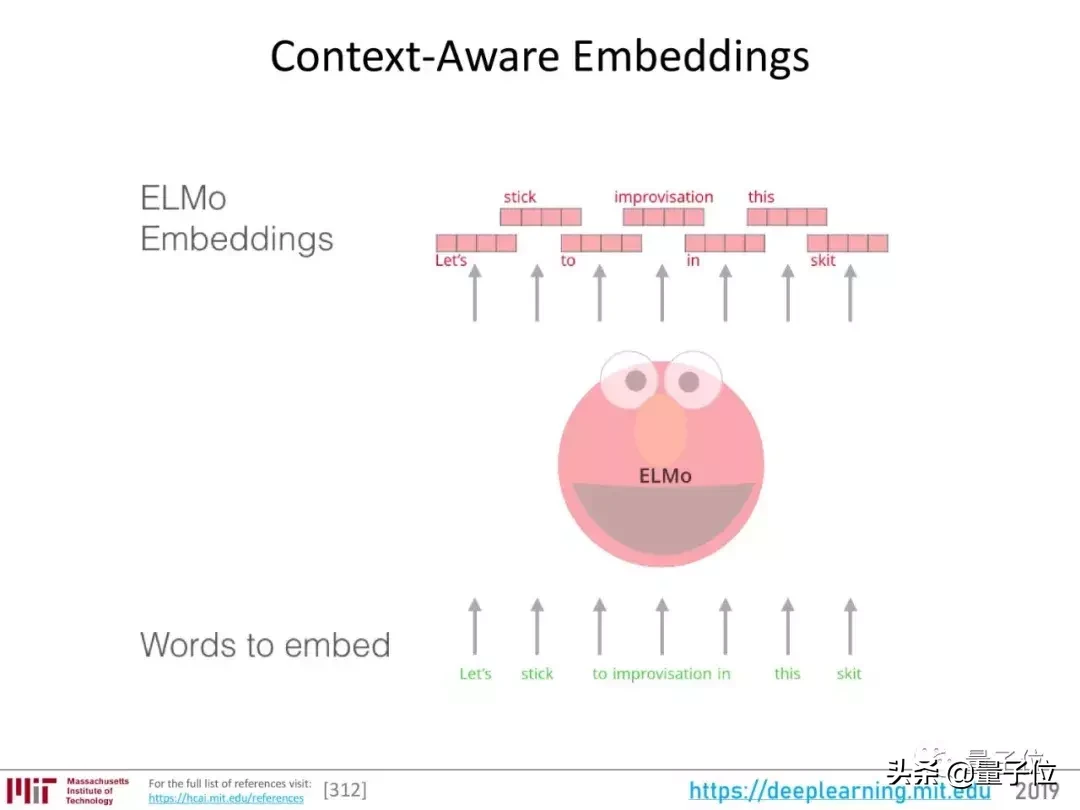

后来,ELMo使用双向LSTM进行单词嵌入。

双向LSTM不仅考虑单词后面的序列,还考虑单词前面的序列。因此,ELMo单词的嵌入考虑了上下文,可以更好地表示单词。

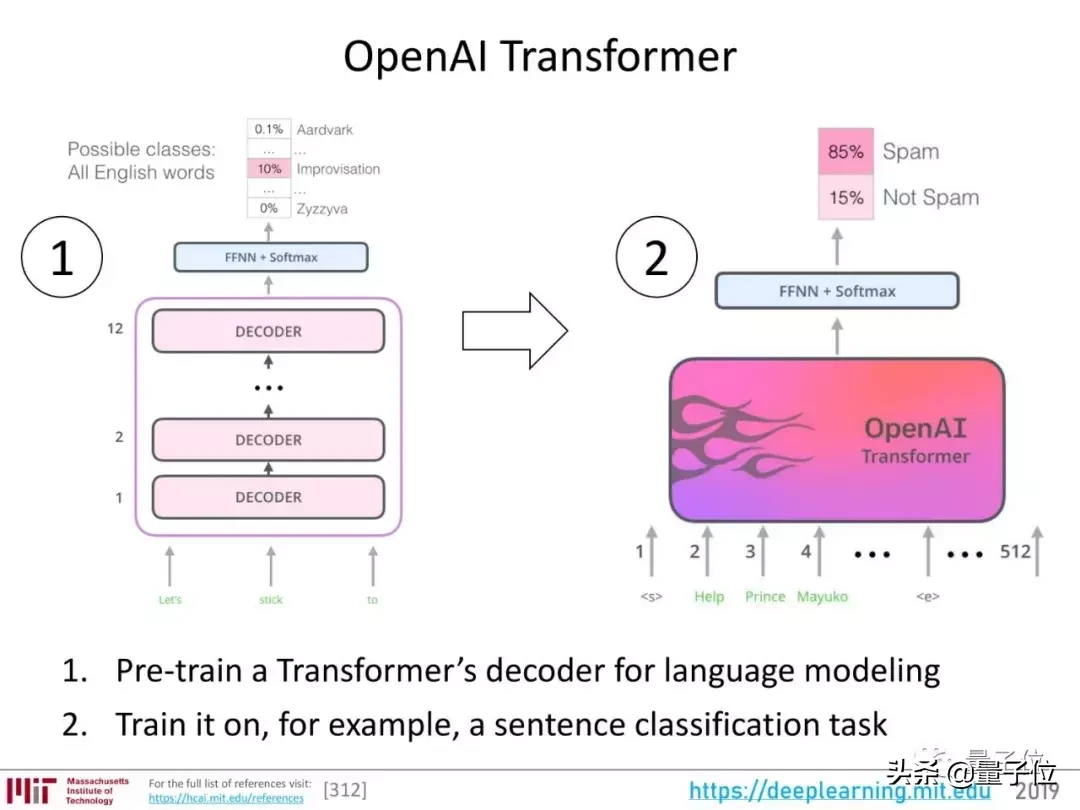

然后是开放的变形金刚。

也就是先训练一个Transformer解码器完成语言建模,然后再训练它完成特定的任务。

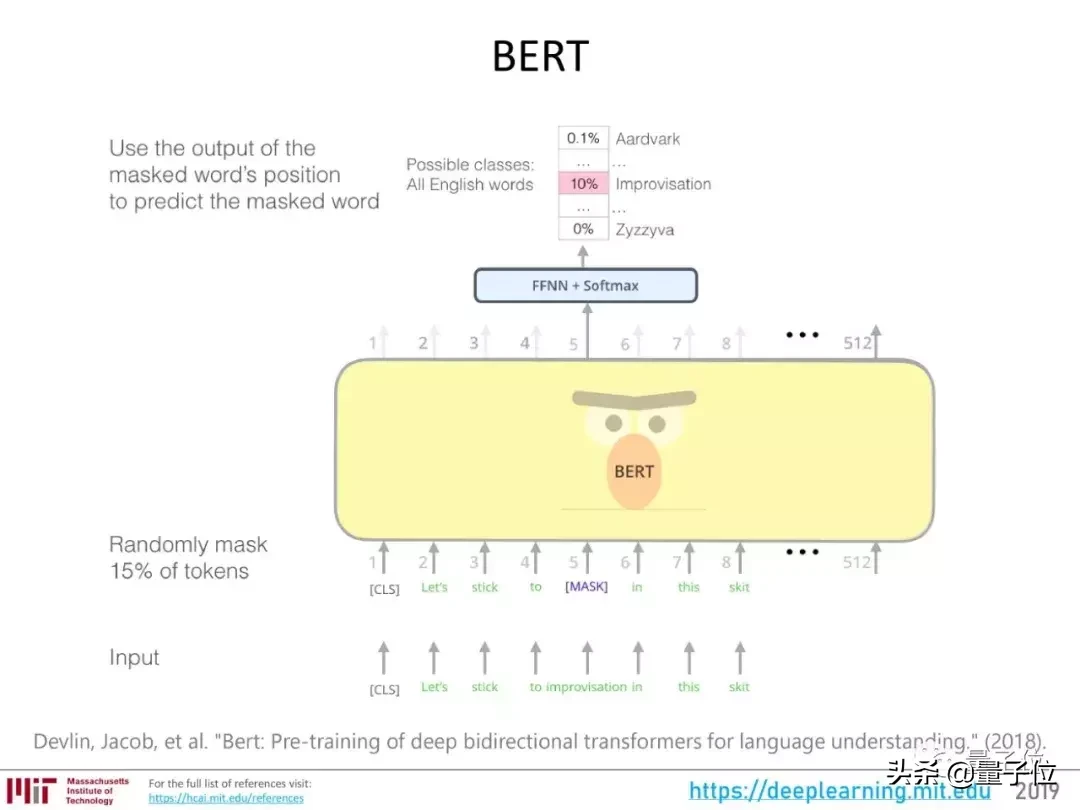

经过这些进步的积累,2018年出现了BERT,带来了NLP各项任务性能的显著提升。

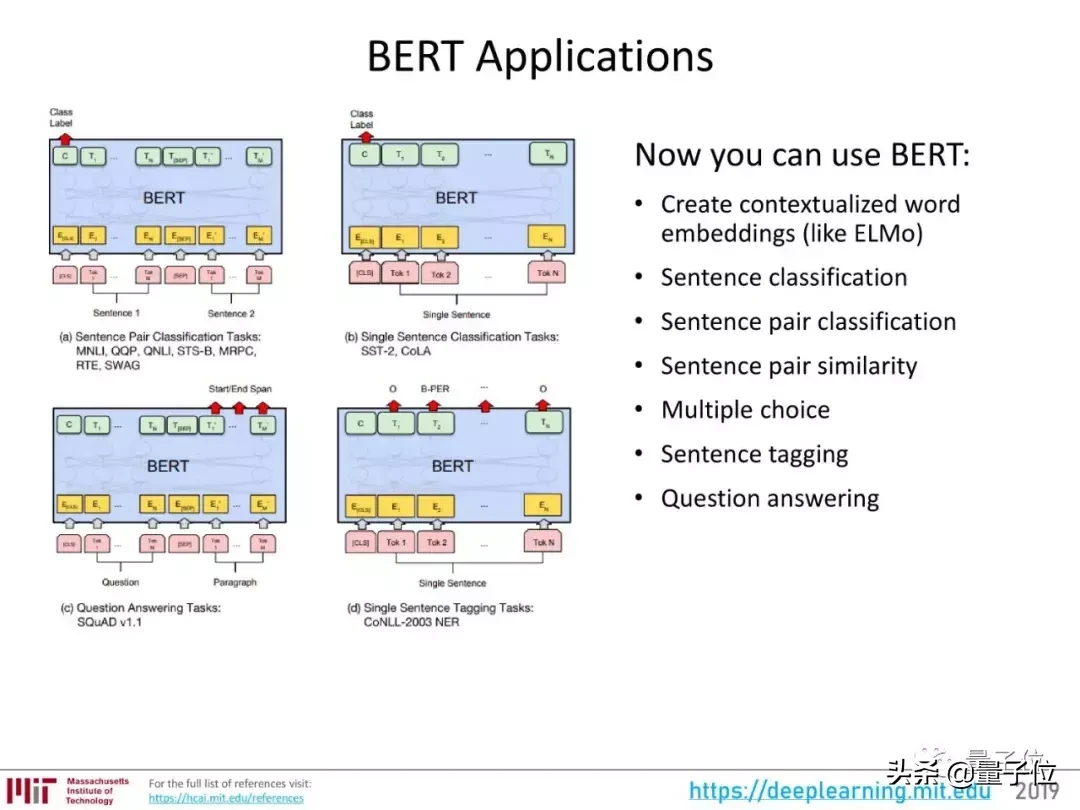

它可以用于各种NLP任务,例如:

像ELMo一样创建上下文单词嵌入;句子分类;句子分类;计算句子对的相似度;以选择题的形式完成问答任务;给句子贴标签;完成普通的问答任务。在Quantum之前,有文章回顾了2018年深度学习和NLP的进展,也详细讨论了BERT。

阅读2018年所有AI技术突破。

不,只是伯特!盘点2018年NLP的10大精彩创意

特斯拉AutoPilot II硬件

特斯拉的出现并不意外。之前推出过量子比特。莱克斯老师是马斯克的小粉丝。

作为神经网络大规模应用的代表,确实值得一提。

Autopilot的第二代硬件使用了英伟达的Drive PX 2,同时还配备了8个摄像头来获取输入数据。

Inception v1神经网络运行在Drive PX 2上,它利用摄像头获取的各种分辨率的数据进行各种计算,比如分割可以前进的区域,物体检测等等。

这套系统将神经网络带入了车主的日常生活。

AdaNet:集成学习的AutoML

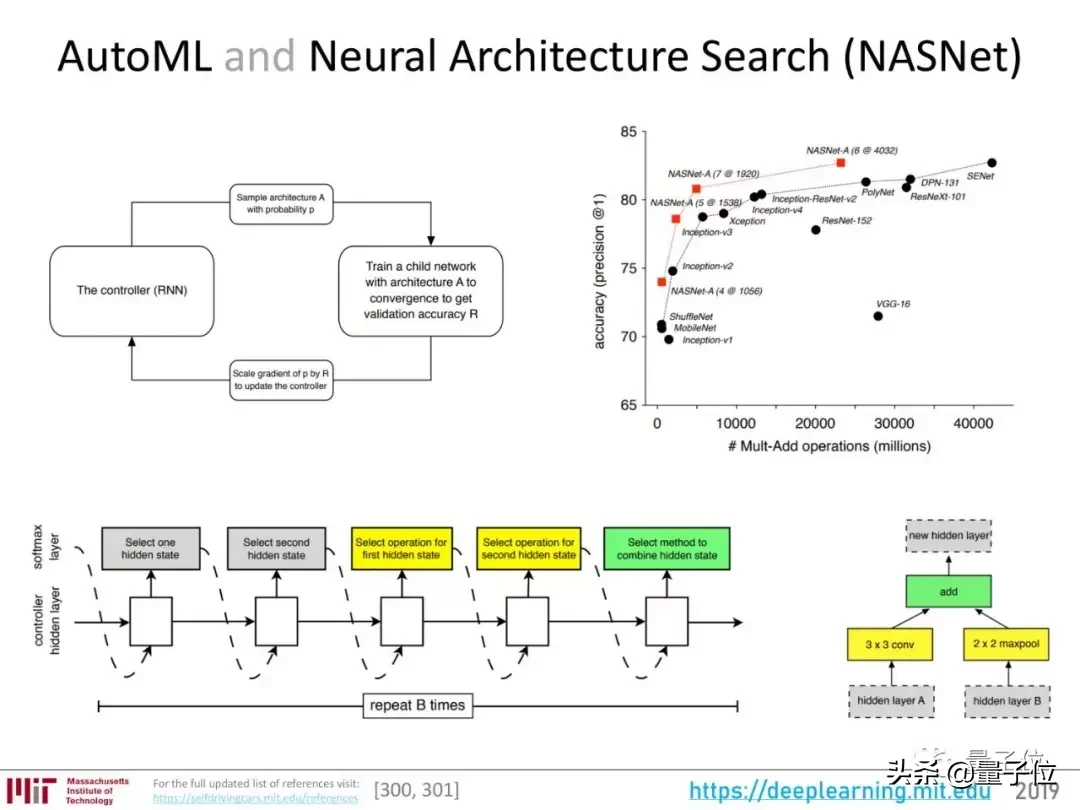

AutoML是机器学习的梦想;

把机器学习的一个方面或者整个过程自动化,扔一个数据集进去,让系统自动决定所有的参数,从层、模块、结构到超参数.

谷歌的神经架构搜索在效率和准确率上都取得了不错的成绩。

2018年,AutoML有了一些新的发展,AdaNet就是其中之一。

它是一个基于Tensorflow的框架。和AutoML一样,它也使用强化学习。然而,AdaNet不仅可以搜索神经网络架构,还可以学习集合,并将最佳架构组合成高质量的模型。

想了解更多关于AdaNet的内容,可以参考量子位之前的文章:

谷歌开源集成学习工具AdaNet:2017年提出的算法终于实现了。

自动增强:通过强化学习增强数据

从2012年的“ImageNet Moment”到现在,图像识别的新算法层出不穷,成果也在不断提升。

在计算机视觉中,数据量非常重要,数据增强也是提高识别率的重要方法。然而,关于数据增强的研究却很少。

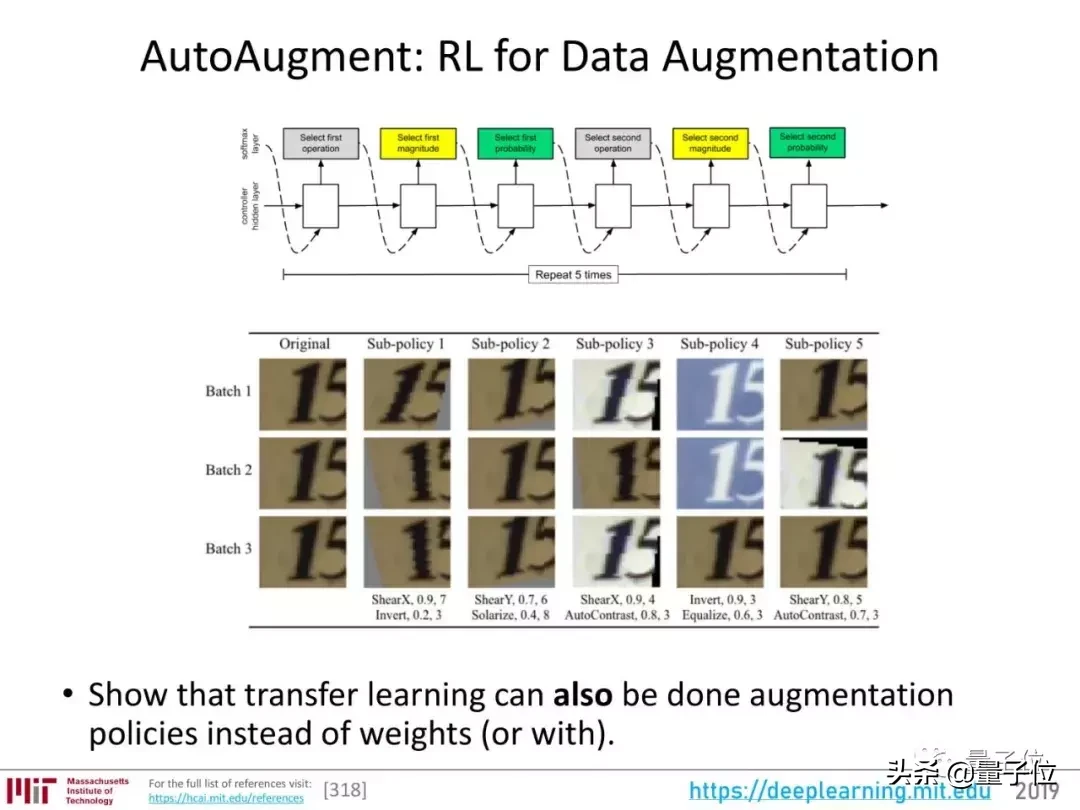

2018年,在自动搜索神经架构之后,谷歌还自动化了数据增强这一步。

自动增强可以根据数据集学习这类图像的“不变性”,知道哪些特征是核心。然后,神经网络在增强数据时要保持核心特征不变。

例如,当它自动增强门牌号数据集时,它经常使用剪切、翻译和反转颜色等方法。然而,在ImageNet等自然照片数据集上,它不剪切或反转颜色,而只是微调颜色、旋转等。

这个过程类似于计算机视觉中常用的迁移学习,只不过不是迁移模型的权重,而是大数据集迁移中体现的数据增强策略。

要了解有关自动增强的更多信息,建议阅读:

通过自动增强提高深度学习性能

用合成数据训练深度神经网络

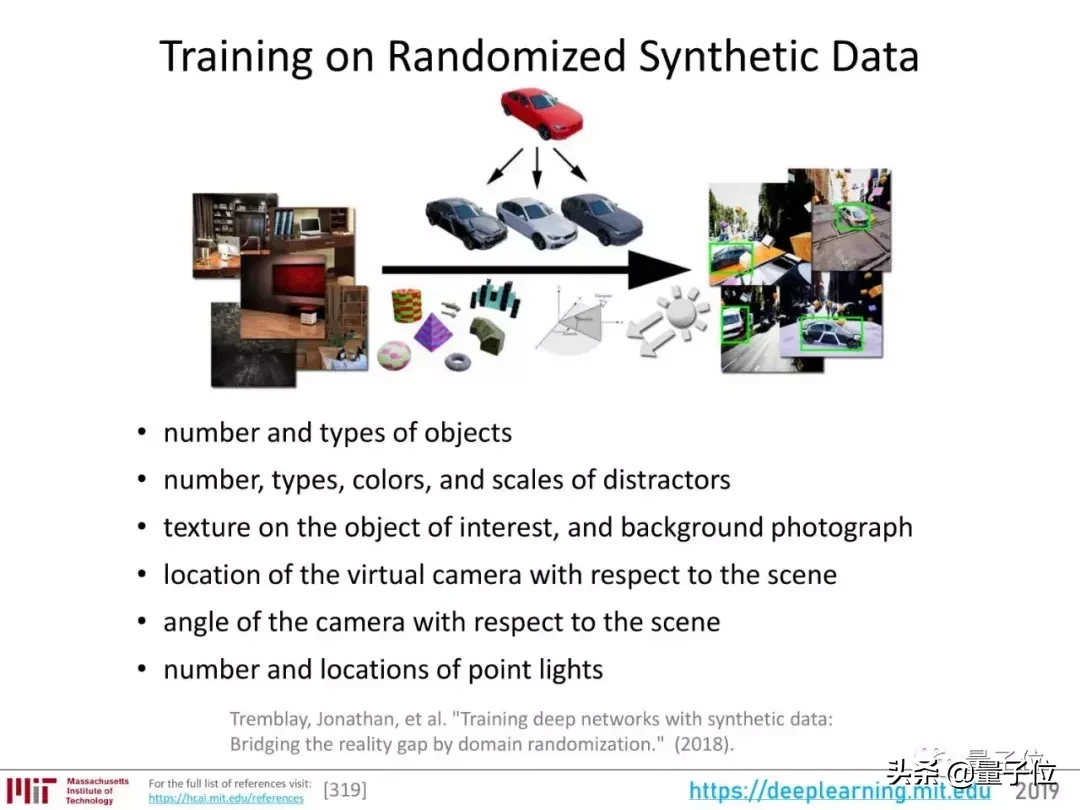

很多机构都在研究如何用合成数据训练神经网络,英伟达是主力。

英伟达非常擅长创造接近现实的场景。他们在2018年的一篇关于用合成数据训练深度神经网络的论文中充分利用了这一点。用合成数据训练的模型的结果不亚于真实数据的结果。

数据合成也非常灵活。比如汽车,房子,可以合成各种数量,类型,颜色,纹理,背景,距离,透视,灯光等等。

如何用合成数据训练模型?Nvidia的这篇论文值得一读:

用合成数据训练深度网络:通过领域随机化弥合现实差距

https://arxiv.org/abs/1804.06516

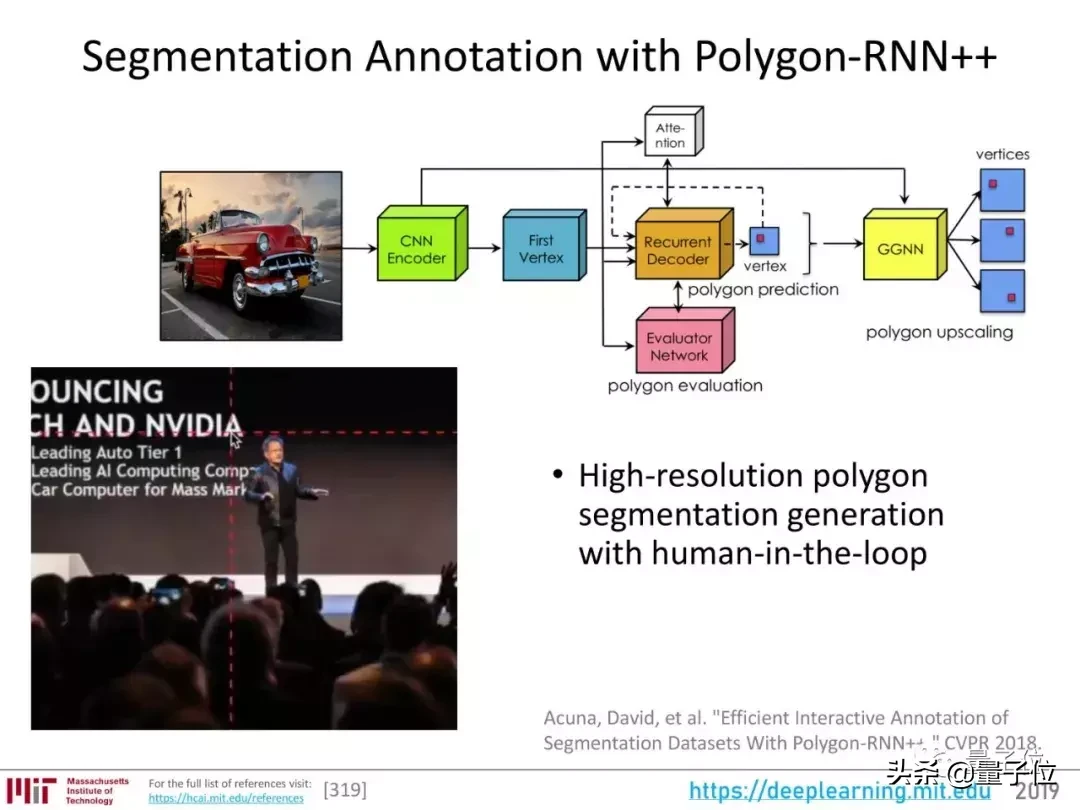

多边形RNN:图像分割的自动标注

在深度学习模型的训练过程中,数据标注是一个非常费时费力的环节。标注语义分割图就更麻烦了。

多边形RNN是一种自动标记图像的方法,它可以自动生成一个多边形来标记图像中的对象。

它使用CNN提取图像特征,然后使用RNN解码多边形的顶点,并提出几个候选多边形。然后,评估网络从候选人中选出最好的。

这也是让深度学习尽可能自动化的一种努力。

在Polygon-RNN的主页上,您可以找到该工具的论文、演示、代码和其他资料:

http://www.cs.toronto.edu/polyrnn/

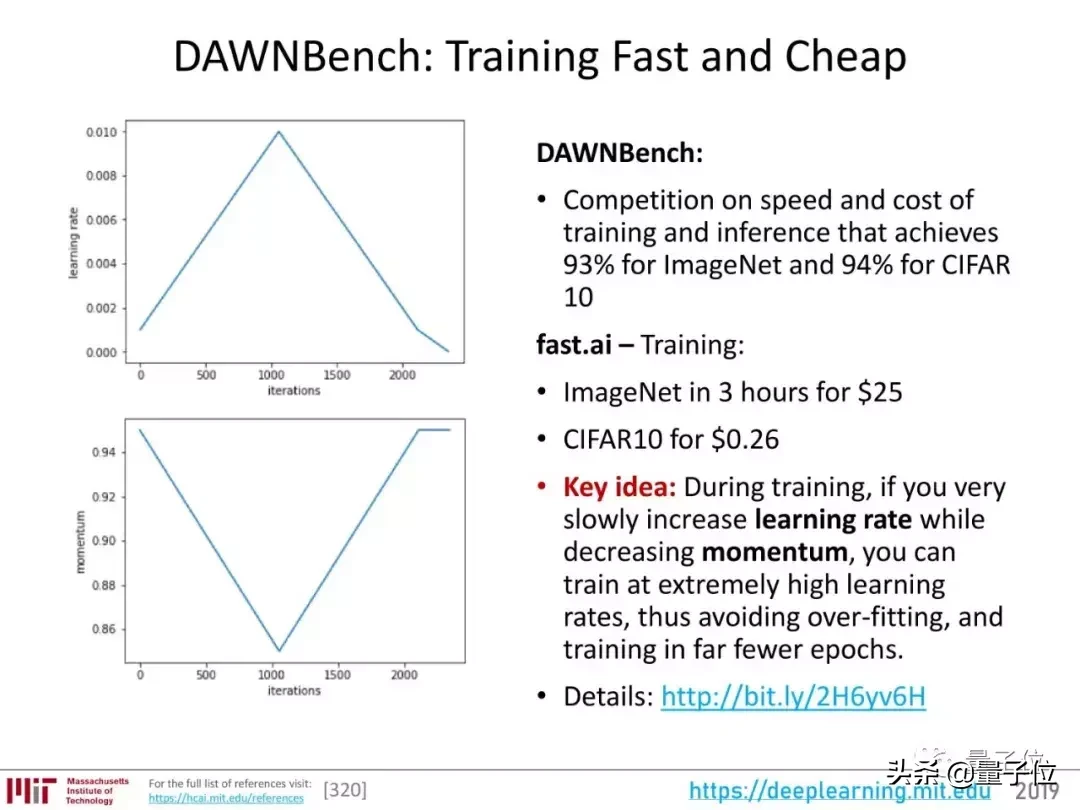

DAWNBench:寻找一种快速便宜的训练方法

除了让深度学习尽可能自动化,还有一个一直关注的研究方向:让它更容易使用。也就是又快又便宜。

斯坦福提出的DAWNBench基准评估模型的速度和成本。它以ImageNet上93%的准确率和CIFAR上94%的准确率测试了各种模型、框架和硬件的训练和推理速度和代价。

官网在这里:

https://dawn.cs.stanford.edu/benchmark/

Fast.ai在速度和便宜方面都取得了不错的成绩。利用他们租用的亚马逊AWS的云计算资源,他们在18分钟内在ImageNet中将图像分类模型训练到93%的准确率。

他们方法的关键是在训练过程中逐步提高学习率,降低动量,让他们以非常高的学习率进行训练,避免过度拟合,减少训练周期。

量子比特已经被引入:

40美元18分钟训练整个ImageNet!他们说,这个成绩是每个人都能达到的。

BigGAN:最先进的图像合成研究

在用GAN合成照片的方向上,2018年最显著的成就是DeepMind的BigGAN。

它使用的基本模型没有太大变化。关键在于提高训练规模,增加模型的容量和训练批量。

当比根把它提交给ICLR匿名评论时,学术圈已经沸腾了,因为效果真的是史上最好的。

现在,BigGAN的试玩正式开放,大家可以体验一下:

史上最强甘:培训费用10万,现在免费体验,鬼畜画风写实。

视频到视频合成

在这个领域有一个非常有趣的研究,那就是Nvidia和MIT的“视频到视频合成”。

只要你有一张动态语义图,你就可以得到一个和现实世界几乎一模一样的视频。

通过简单的草图,您还可以生成细节丰富、动作流畅的高清人脸:

甚至全身都可以处理,跳舞也没有压力:

论文和代码已经发表,量子比特已经详细介绍。你可以在这里阅读:

真实到可怕!英伟达麻省理工学院制造了马良的魔法笔。

语义分割

感知的问题可以分为三个层次。目前研究最充分的是分类,也就是图像识别。

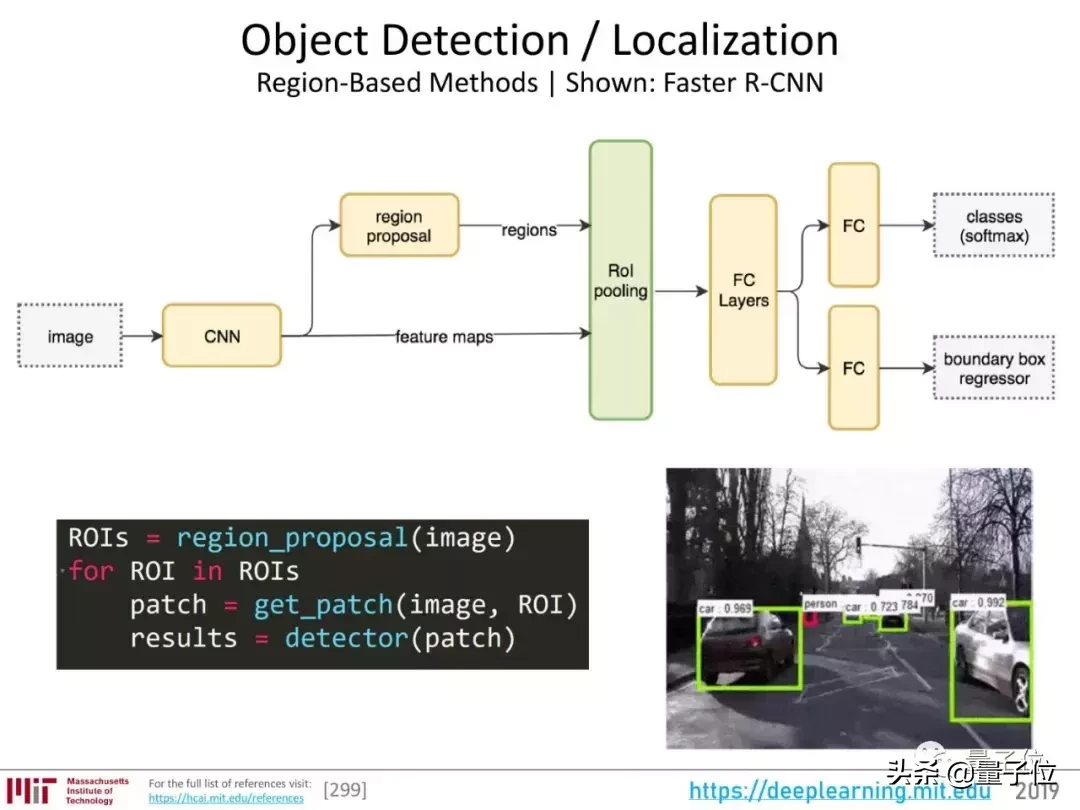

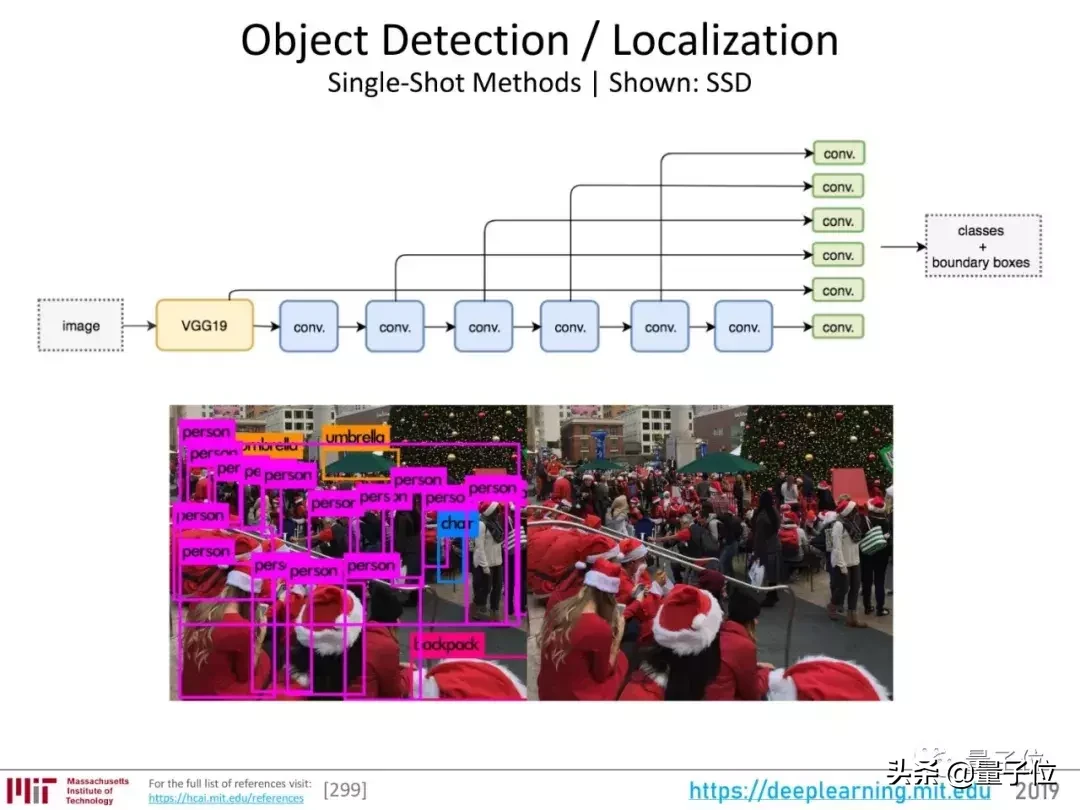

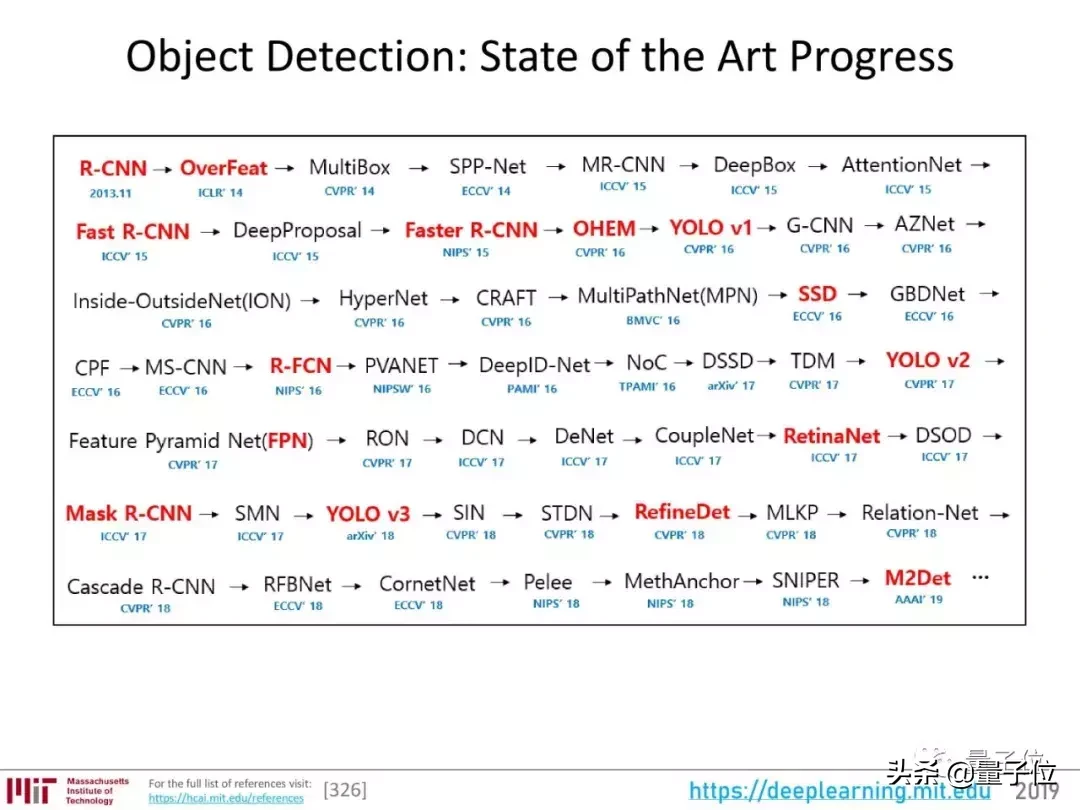

然后,是目标检测:在一幅图像中,框出物体,并识别它是什么。

有许多关于目标检测的研究:

这些工作很多都很刺激,但是莱克斯老师认为没有一个是“突破”。

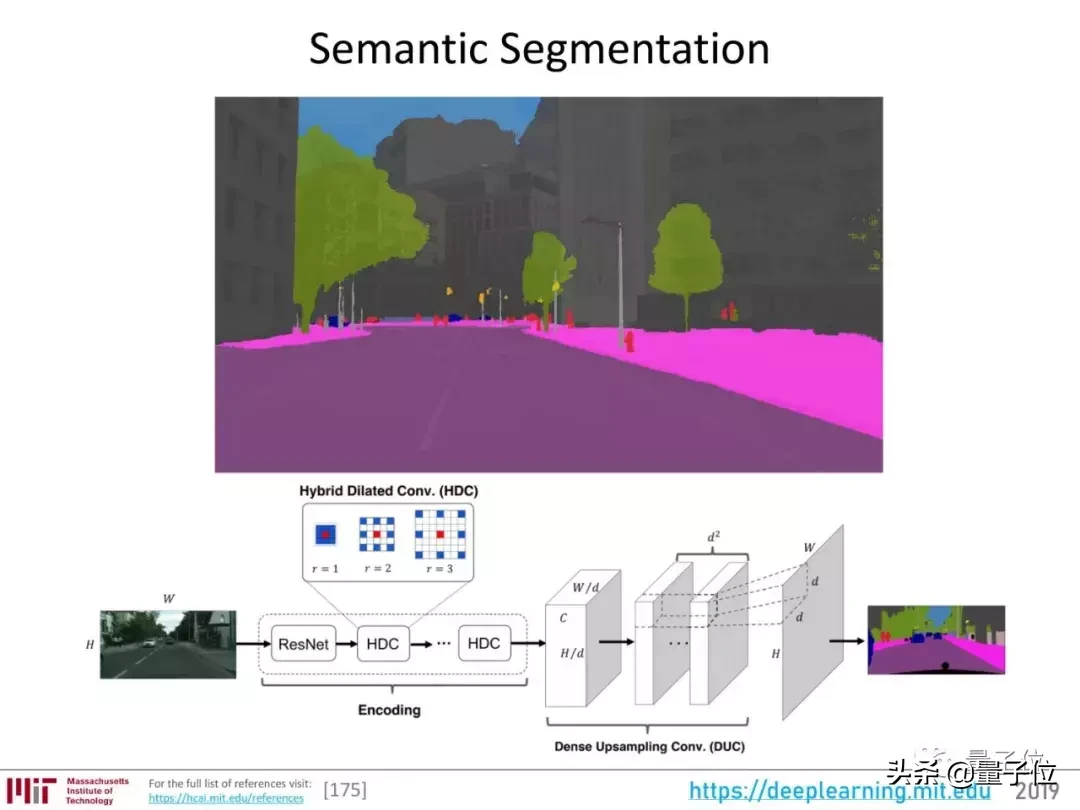

语义分割是视觉感知的最高层次。

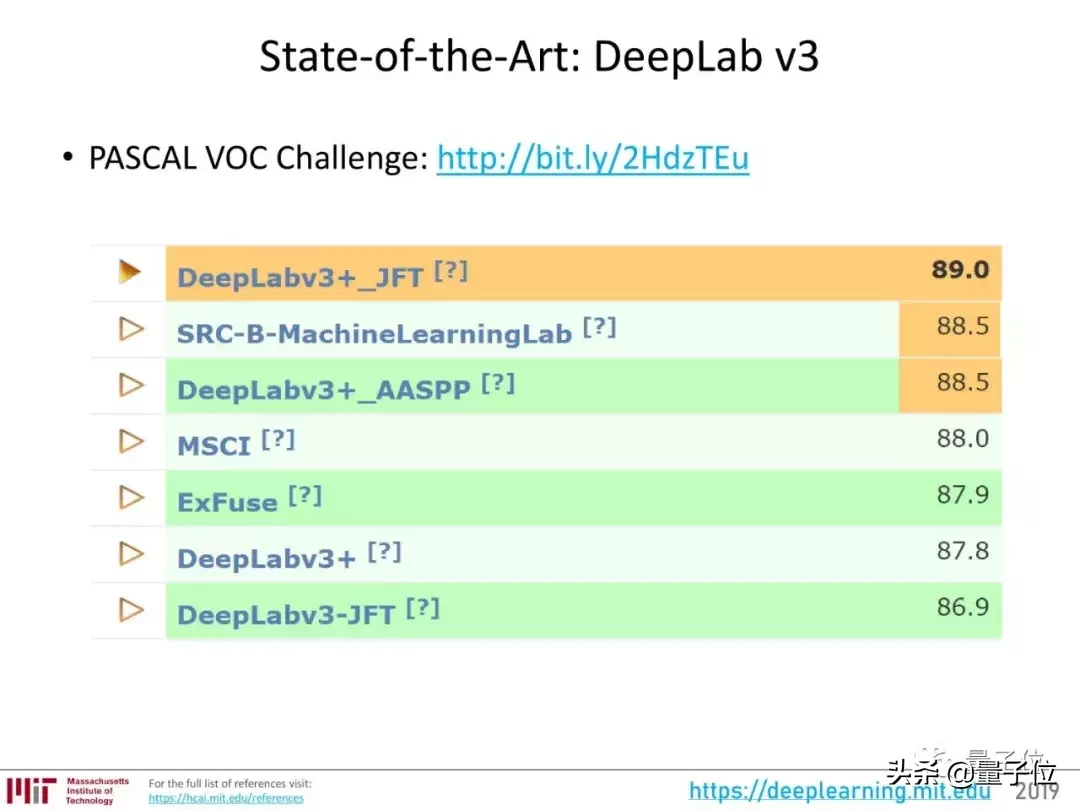

现在,这个领域最好的成果属于DeepLab v3。

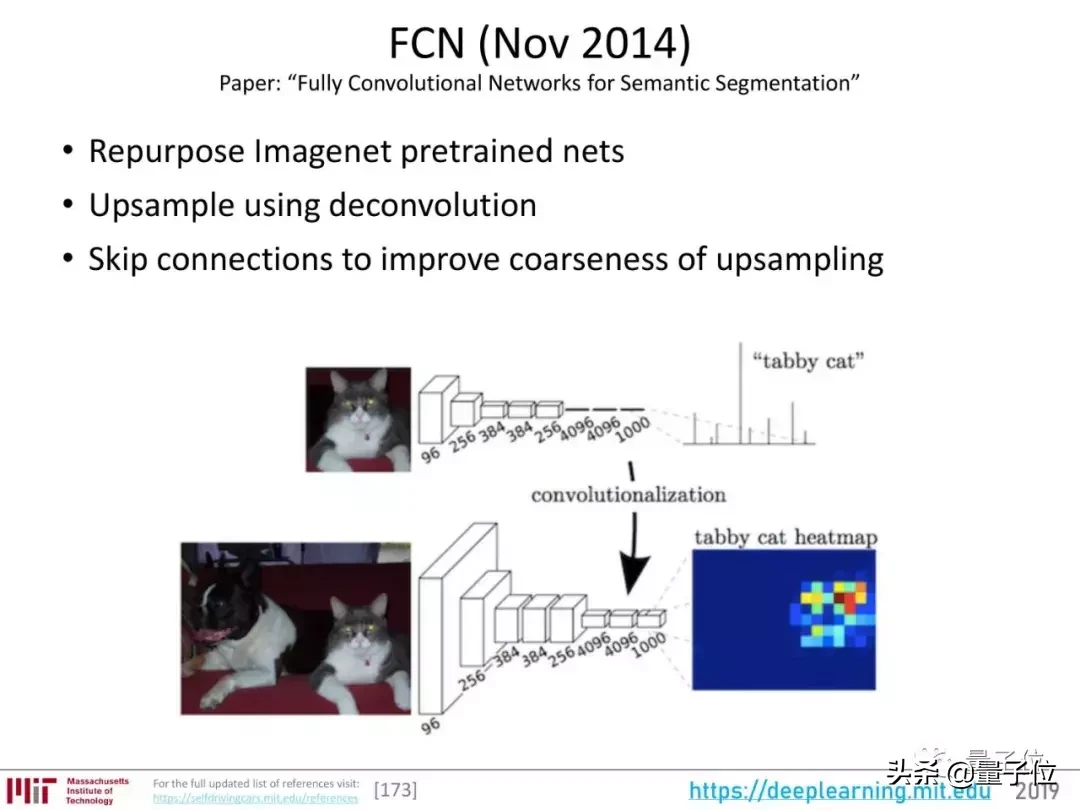

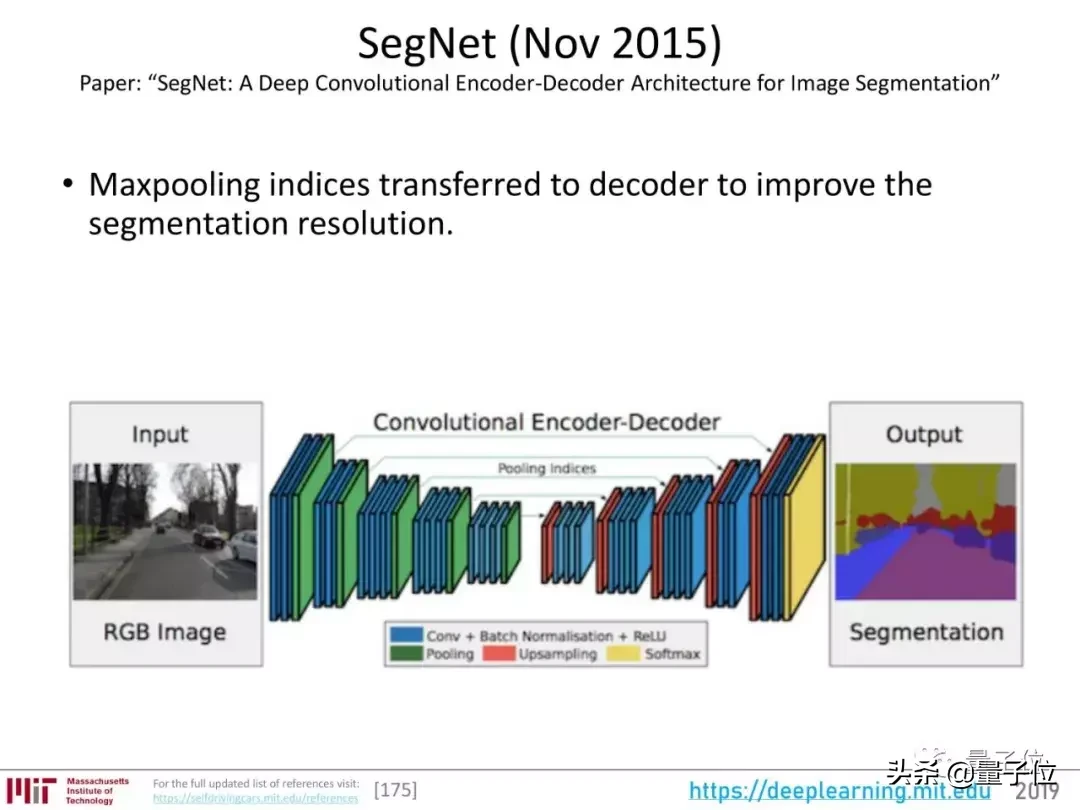

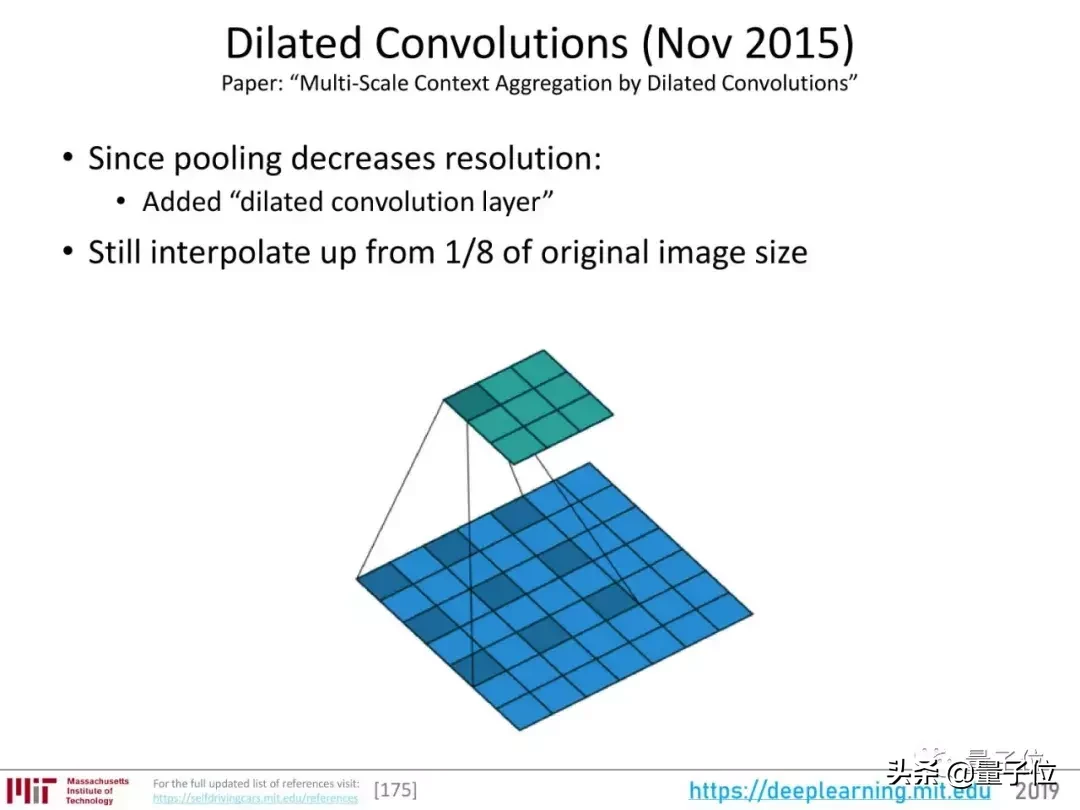

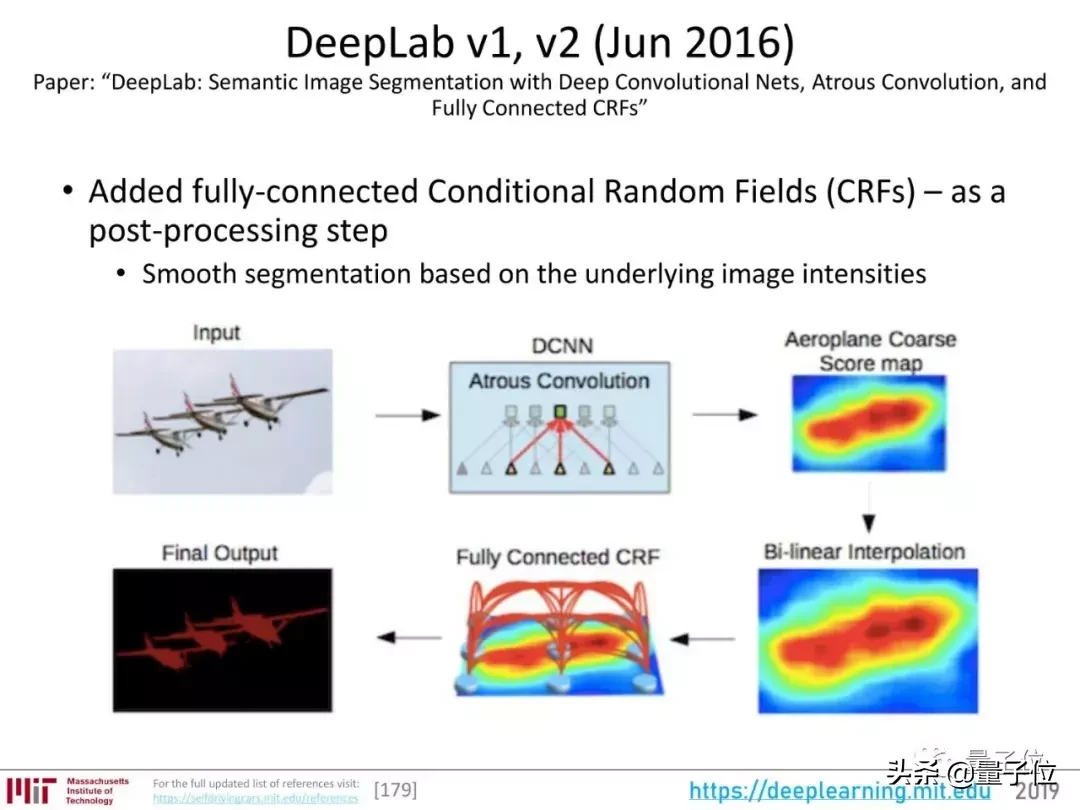

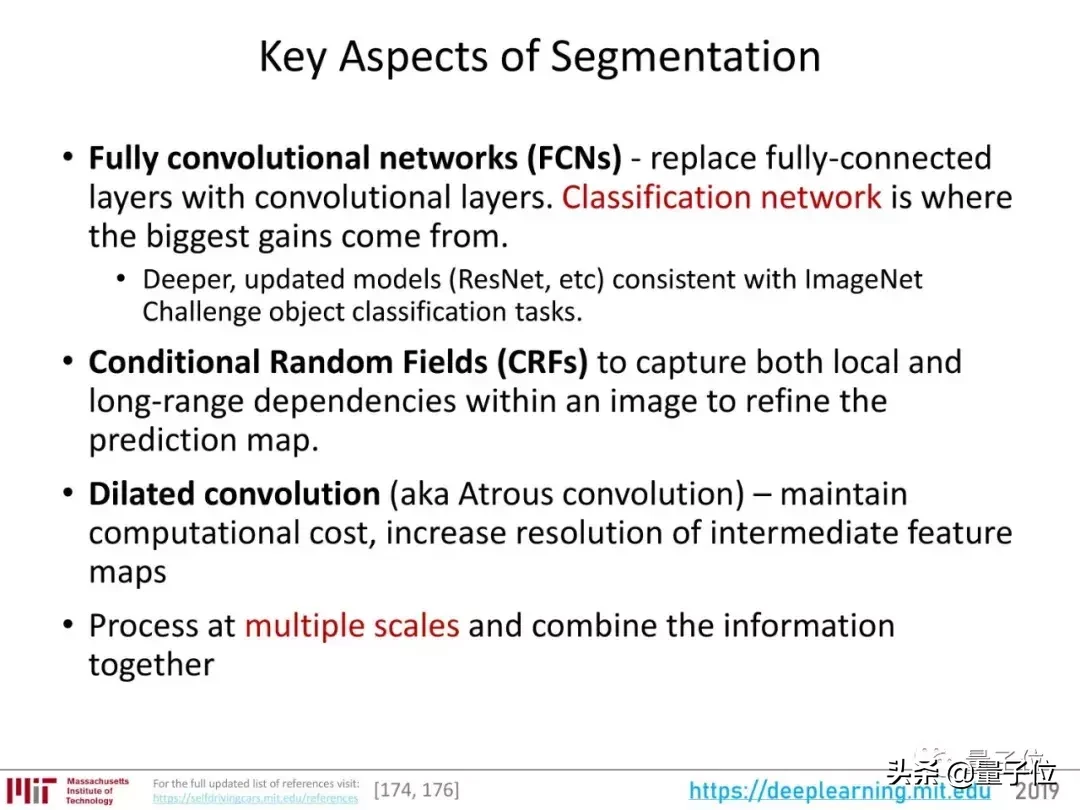

关于语义切分的重要研究,可以说从2014年的FCN,经历了2015年的SegNet和expanded Convolutions的发展,到2016年出现了DeepLab v1和v2的版本。

DeepLab系列使用ResNet提取图像特征,增加了CRF作为后续处理步骤,可以捕捉图像中的局部和长距离依赖,优化预测图,还引入了孔洞卷积。

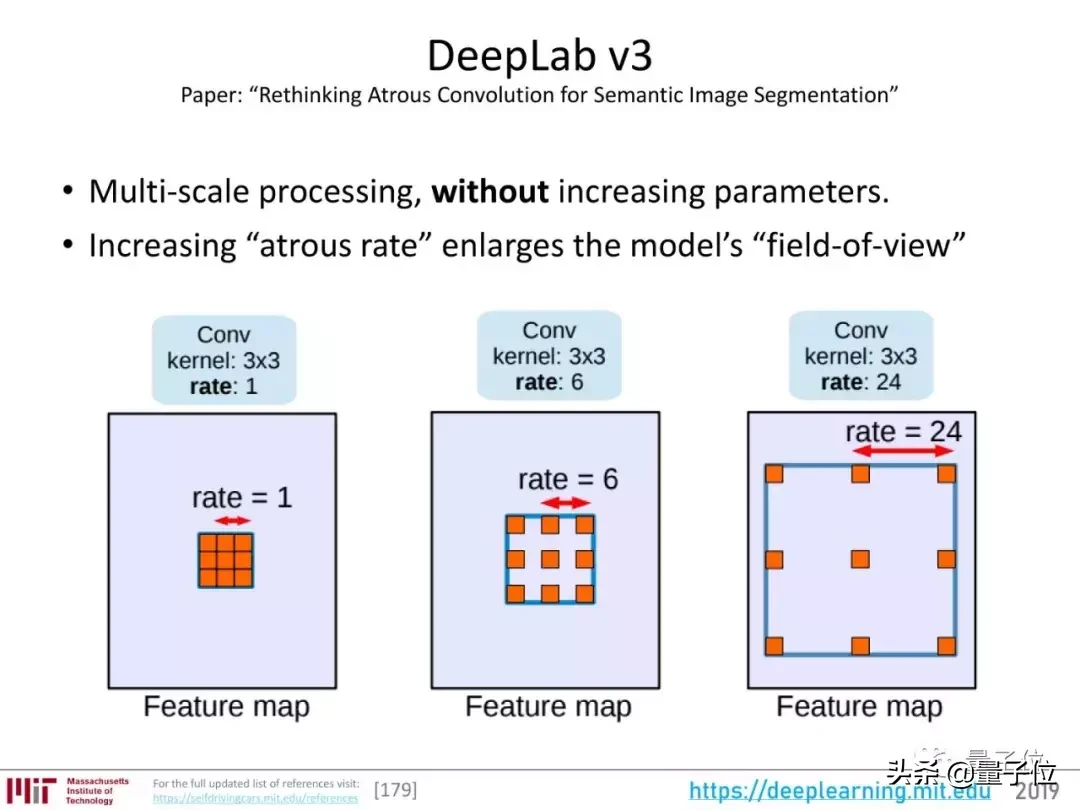

在前两个版本的基础上,DeepLab v3增加了多尺度对象分割的能力。

TensorFlow模型中DeepLab的代码:

https://github . com/tensor flow/models/tree/master/research/deep lab

阿尔法零和开放五

2018年,利用强化学习玩游戏也有了明显的进步。

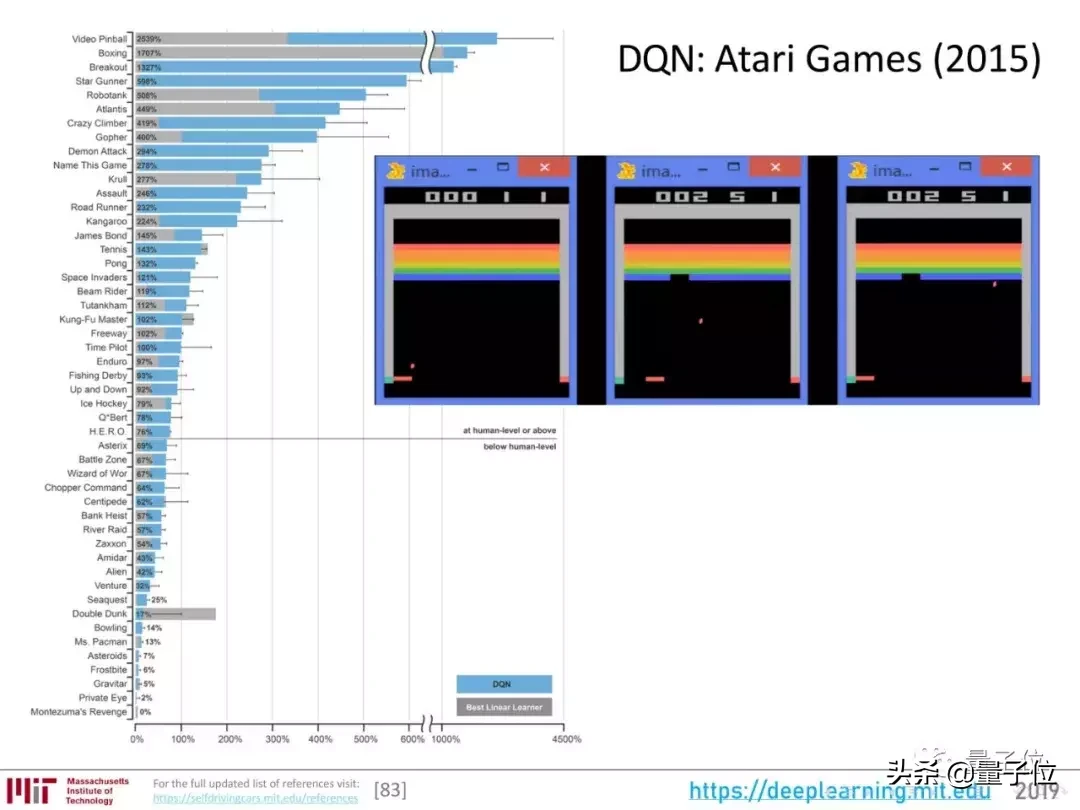

这个领域的第一次尝试是DeepMind用强化学习算法玩了雅达利的小游戏,推出了DQN。

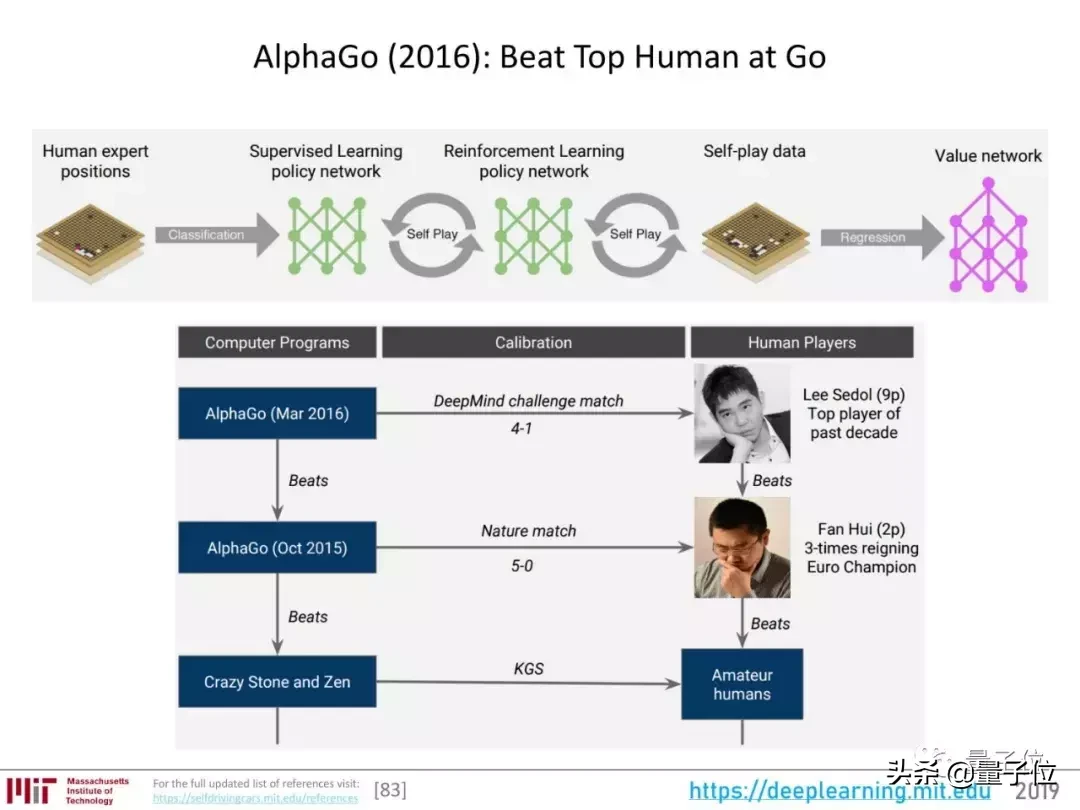

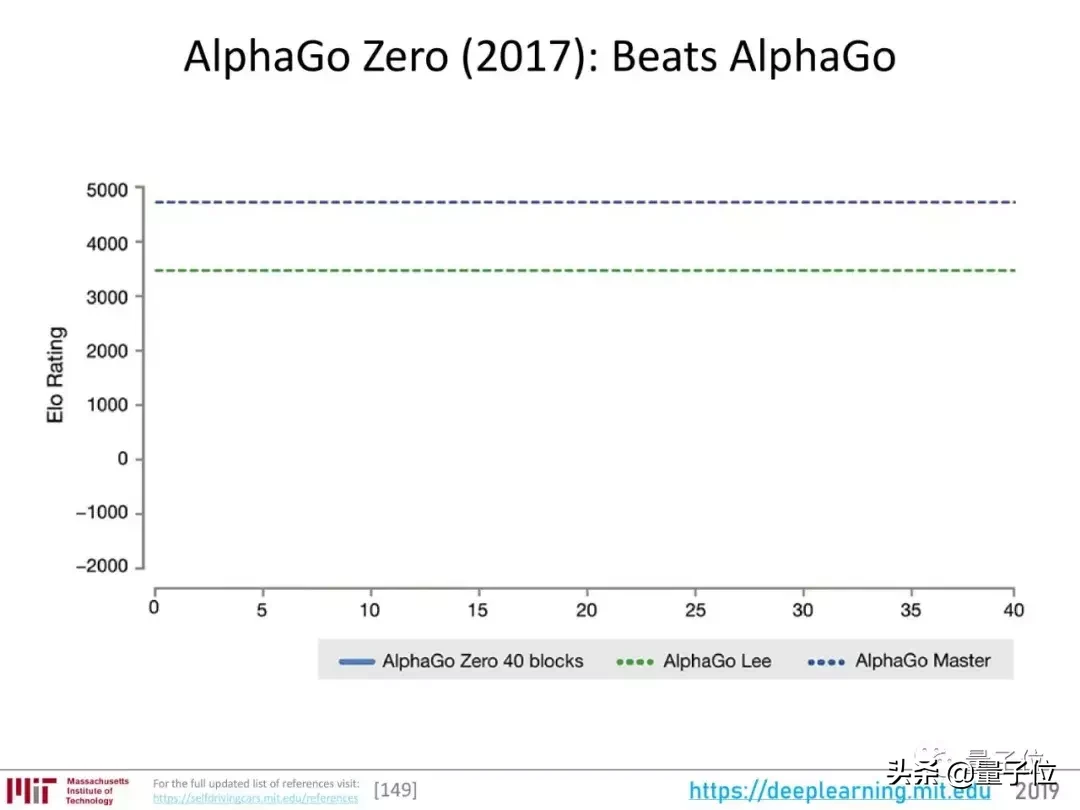

然后,就是围棋AI AlphaGo的一系列知名进展:

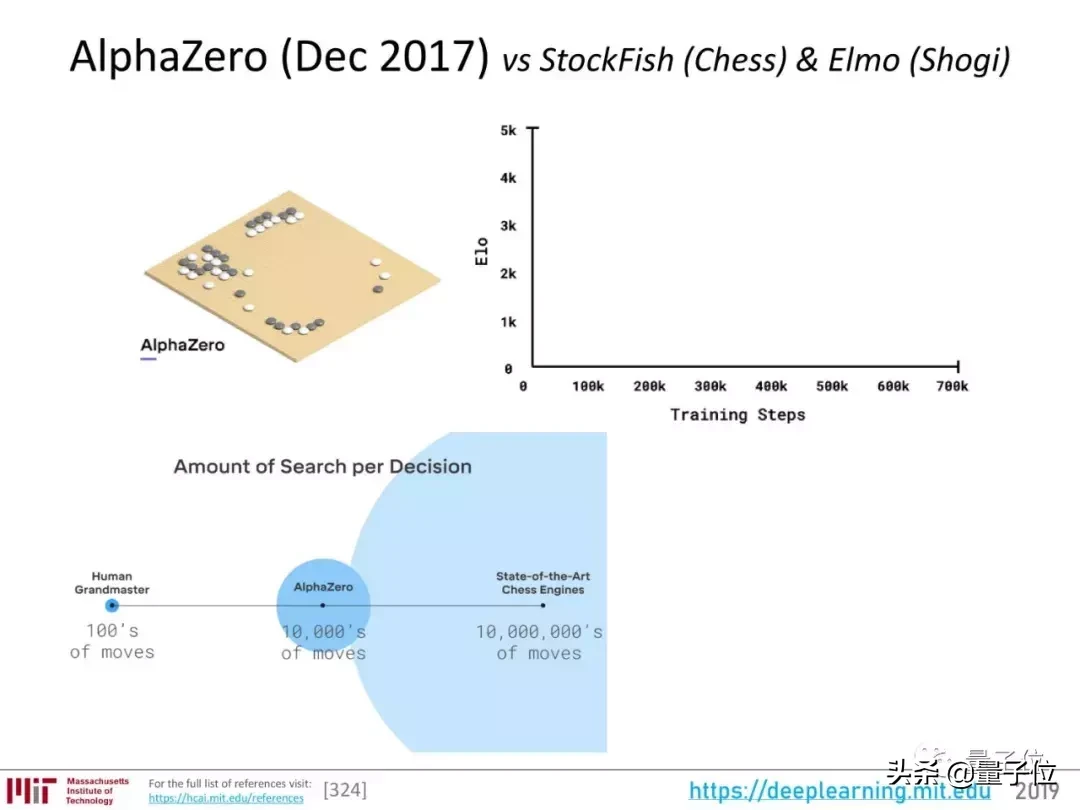

从AlphaGo到AlphaZero的过程,也是越来越省力,机器自主性越来越高的过程。

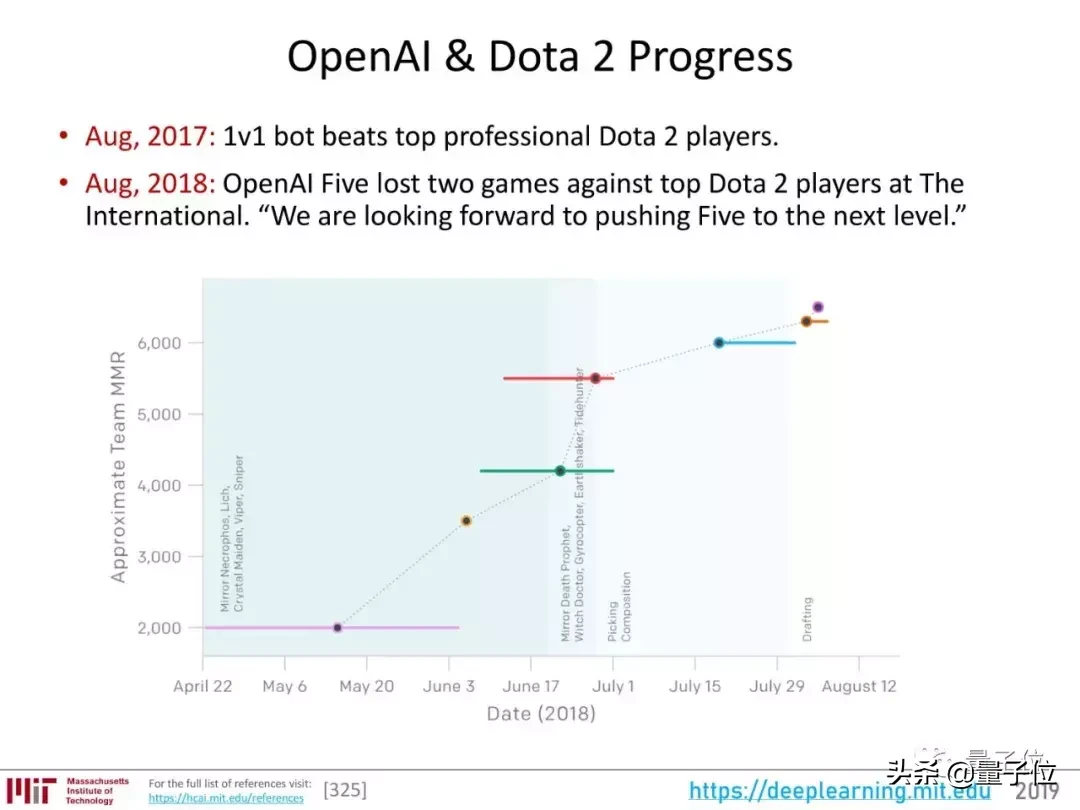

AlphaZero掌握了围棋、象棋、日本象棋,但都是信息完善、规则清晰的游戏。而OpenAI将目光投向了一个更混乱的试验场:Dota 2。

对于强化学习算法,Dota 2更接近真实世界,需要解决团队合作、长时间协调、隐藏信息等问题。

AI在Dota 2上取得的进展如下:

2017年,他们的算法打败了顶级选手登迪;在1v1的比赛中;2018年,5v5的AI战队OpenAI Five在Dota比赛TI中与顶级职业选手对战,输了两场。两场比赛的回顾、技术解读、精彩部分均由qubit报道:

第一次回顾——AI被Dota2职业队打败,打得落花流水!OpenAI独家专访:我们发现了一个Bug。二评——AI又输了!中国传说中的Dota2冠军强强联手,OpenAI进化迅速,但赛后,解读和亮点凸显——一说到劣势就变得愚蠢,发表嘲讽人类的言论.OpenAI这些精彩的DOTA操作是跟谁学的?未来仍需努力。

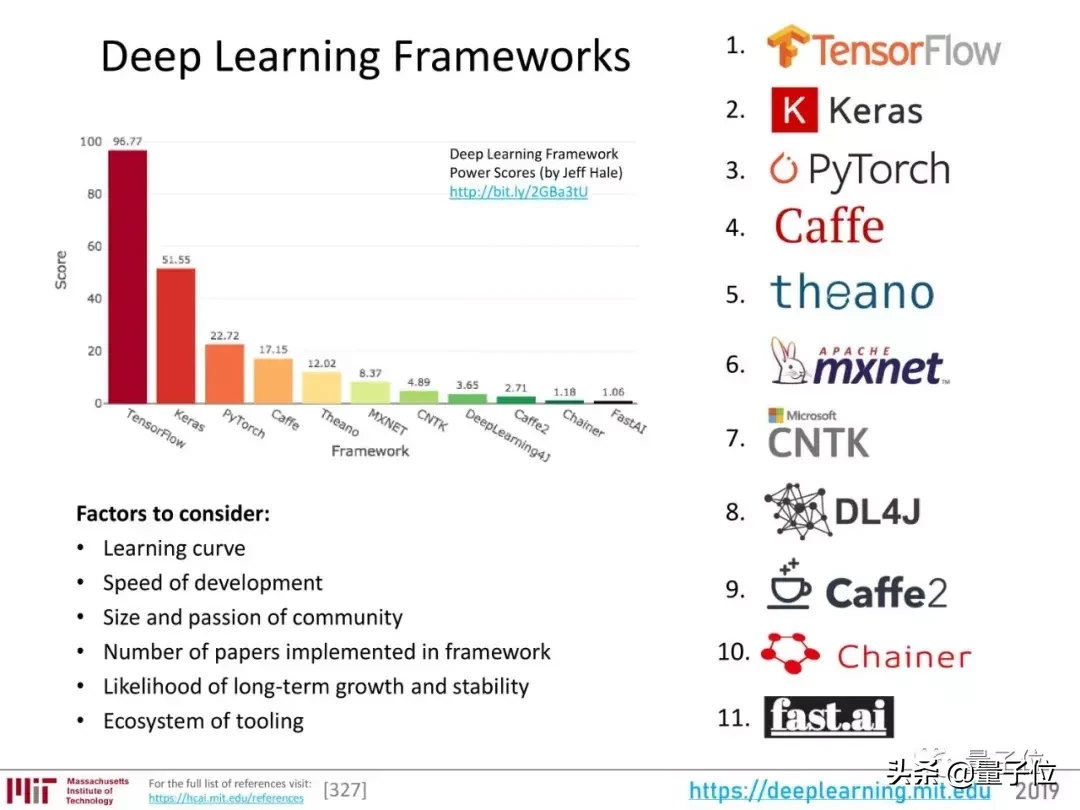

深度学习框架

回顾整个2018年,深度学习框架排名如下:

来源:l https://towards data science . com/deep-learning-framework-power-scores-2018-23607 ddf 297 a

框架会往什么方向发展?这取决于用户关心的以下因素:

学习曲线、发展速度、社区规模和热情、该框架实现的论文数量、长期发展和稳定的可能性、2019年工具生态展望

展望2019年,我们应该仔细思考辛顿谈到的两个观点:

关于反向传播:“我的观点是完全抛弃它,从头再来。”

“未来取决于那些对我说的一切都深感好奇的研究生。”

最后附上完整的PPT:

https://www . Dropbox . com/s/v3rq 3895 r 05 ick/deep _ learning _ state _ of _ the _ art . pdf?dl=0

量子比特(微信官方账号QbitAI)也在网盘上贴了一张PPT,在微信官方账号对话界面的“最前方”就有。

—结束—

真诚招聘

量子正在招聘编辑/记者,工作地点在北京中关村。期待有才华有热情的同学加入我们!详情请在QbitAI对话界面回复“招聘”二字。

量子qbitai头条签约作者

追踪AI技术和产品的新趋势。