来源:本文经艾新媒体量子位(微信官方账号ID: QbitAI)授权转载

来源:本文经艾新媒体量子位(微信官方账号ID: QbitAI)授权转载

本文约2500字。建议读8分钟。

本文向您介绍Adobe发布的新magic,只需2-3秒即可获得三维效果。

你离礁石越来越近,仿佛一秒钟就要撞上了。

但是,这个动画并不是从人类拍摄的视频中剪辑出来的。

是Adobe发布的新魔术让这张静态照片变得立体。整个过程只需要2-3秒:

这种在纪录片等视频后期制作中经常使用的特效处理,被称为本伯恩斯效应。

最初,它只是2D缩放(在下图的左边)。通过平移和缩放静止图像,产生视差,从而实现动画效果。

但Adobe的3D效果(上图右)不仅有平移和缩放,还有视角转换,给人更身临其境的体验。

要实现它,专业设计师需要在Photoshop等软件上花上几个小时。

而且制作成本很高,一张照片大概要40-50美元(约合人民币280-350元)。

Adobe也出现在ACM主办的计算机图形学顶级期刊TOG上,引起了很多讨论和关注。有很多激动的网友给出“三通”:

难以置信。太神奇了。胡说八道。这根本不是简单的缩放。

透视原理决定了前景比背景移动/缩放更剧烈。

所以前景移动的时候,背景也要固定,也要移动。

AI的背景修复非常自然,手法明显优于“前辈”:

外形奇特的教堂

而且,不管背景简单还是复杂,AI都不怕。

比如你去沙发,沙发挡住了后窗外面的草:

背景颜色和结构很复杂,但AI不是瞎子。

如果你觉得刚才视角的变化只是从远到近,那就不够复杂了。然后看看这个古老的步骤:

看起来你是在走上台阶,所以你在慢慢转向它的方向。

况且一个老楼道,你所在的地方,从仰视的角度看,好像是直视前方。

当然不仅仅是风景,人像也可以处理。

例如,草地上的新娘可以从远处观看,也可以从近处欣赏:

正如我们在开头所说的,所有的转换都是通过一个静态图来完成的。

自然,这不是普通的缩放所能做到的:

左边是普通变焦,右边是3D魔术。

那么,是什么样的技术做到了呢?

结合上下文感知的三步边界确定

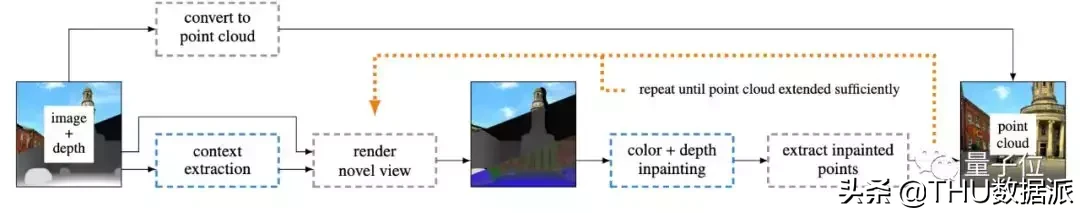

从单幅图像合成逼真的摄像机运动效果有两个基本问题需要解决。

首先需要设置新的摄像机位置,合成新的视图,准确还原原视图的场景几何。

其次,根据预测的场景几何结构,新视图应该在连续的时间线上合成,这涉及到去块等图像修复方法。

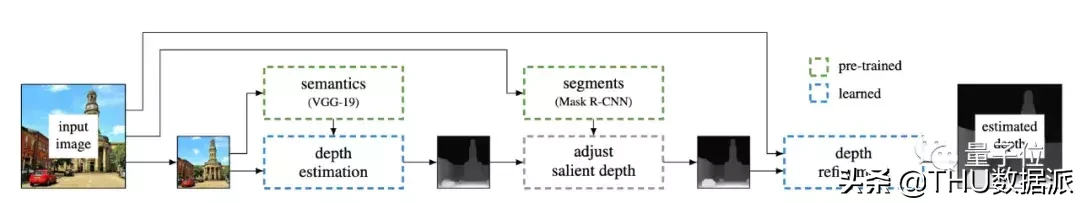

研究人员使用三个神经网络来构建处理框架。

用于训练的数据集由计算机生成。研究人员从UE4 Marketplace2收集了32个虚拟环境,用虚拟相机拍摄了32个环境中的134041个场景,包括室内场景、城市场景、乡村场景和自然场景。每个场景包含4个视图,每个视图包含颜色、深度和法线图,分辨率为512512像素。

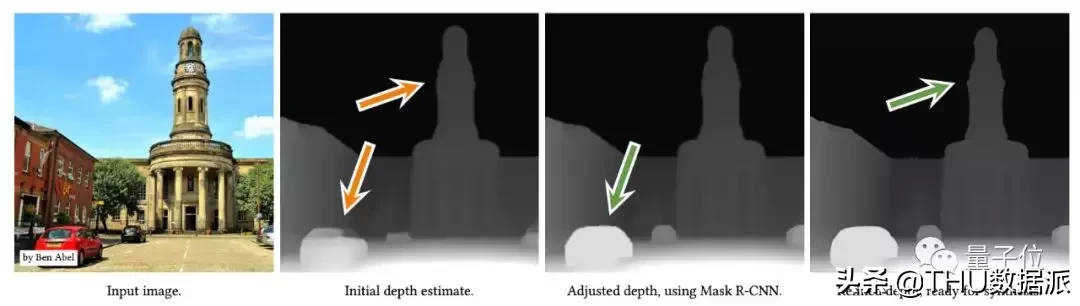

指定一个高分辨率的图像,首先根据其低分辨率版本估算粗糙度深度。这一步由VGG-19实现,它根据VGG-19提取的语义信息指导深度估计网络的训练,并由具有地面真值的计算机合成数据集进行监督。这样就可以提取出原始图像的深度图。

第二个网络是Mask R-CNN。为了避免语义失真,并行于VGG-19,对输入的高分辨率图像进行Mask R-CNN分割,然后根据分割结果调整深度图,保证图中的每个物体都映射到一个连贯的平面上。

最后,通过使用深度细化网络并参考输入的高分辨率图像,对提取的粗略深度进行上采样,以确保更精确的深度边界。

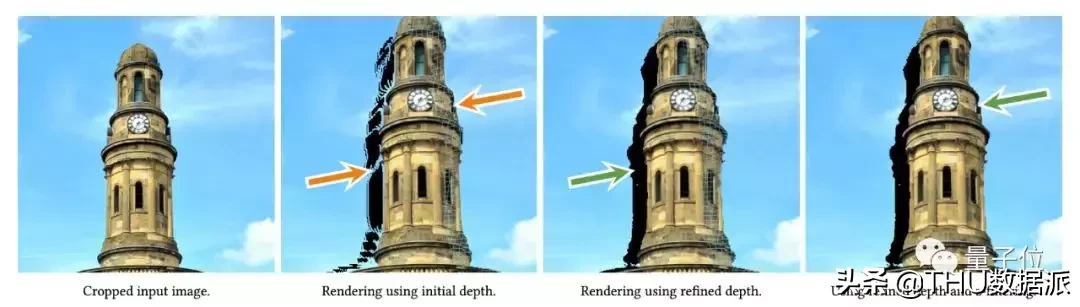

之所以采用深度细化网络,是因为在切割物体的过程中,物体很可能在边界处被撕裂。

有了从输入图像中获取的点云和深度图(注:点云是指3D扫描获取的物体外观表面的点数据的集合),就可以渲染出连续的新视图。

但是,这里会出现一个新的问题,3354。当虚拟相机向前移动时,物体本身会有裂痕(下图中塔的右侧被网格切开)。

为了解决这个问题,研究者采用了上下文感知修正的方法。

组合上下文信息可以产生更高质量的合成视图。上下文信息描绘了输入图像中相应像素位置的邻域,因此可以通过使用上下文信息来扩展点云中的每个点。

具体来说,第一步是修复颜色和深度图像,以从不完整的渲染中恢复完整的新视图,其中每个像素都包含颜色、深度和上下文信息。

然后,使用图像恢复深度,将图像恢复颜色映射到点云中的新色调点。

重复这个过程,直到点云被充分展开,缝隙被填满,就可以实时呈现一个完整连续的画面。

“用过一次,都说好”

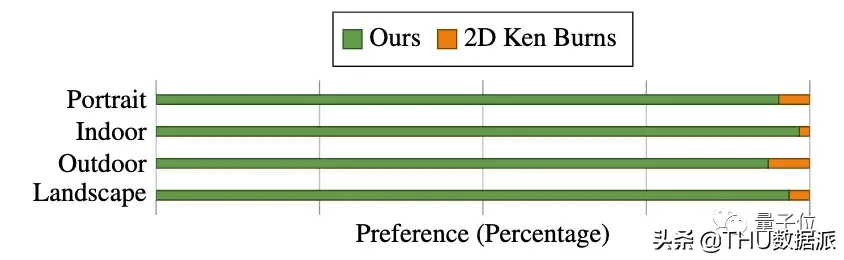

研究人员认为这很好,但这并不好。新方法效果如何,还是用户说了算。

因此,研究小组开发了一个“非正式用户调查”。他们在YouTube上收集了30个由人类创作的3D本伯恩斯视频,并将其分为四组:风景、人像、室内和人工室外环境。每组随机抽取三个视频作为样本。

八名志愿者参与了这项测试。该团队给每个志愿者分配了一张静态图片,并提供了人类作品作为参考。志愿者被要求使用新方法和两个本伯恩斯制作工具,Adobe After Effects Template和移动应用Viewmee,来创建类似的效果。

志愿者会根据自己的主观意见,对每个工具的可用性和质量进行评估。

在志愿者看来,Adobe的新工具无论是效果还是易用性都明显好很多。

来自Adobe的实习生(现转到Google)

这项研究的第一作者是波特兰州立大学的博士生西蒙尼克劳斯(Simon Niklaus),他的研究方向是计算机视觉和深度学习。

他在Adobe Research实习的时候完成了这项工作,现在他在Google实习。

他的博士生导师名叫柳峰,毕业于威斯康星大学麦迪逊分校,现在是波特兰州立大学的助理教授,也是这项研究的作者之一。

他的博士生导师名叫柳峰,毕业于威斯康星大学麦迪逊分校,现在是波特兰州立大学的助理教授,也是这项研究的作者之一。

此外,这项研究还有另外两位作者,龙脉和杨笈每,他们都是Adobe的研究科学家。

西蒙尼克劳斯(Simon Niklaus)在黑客新闻上与网友互动时也谈到了该研究的开源计划。

他说,他计划公布代码和数据集,但尚未获得批准。因为这项工作是由“实习生”完成的,所以Adobe在开源方面很大方。

当然,这也不能排除他们商业化的可能。如果你对这个研究感兴趣,可以先看看研究论文:

单幅图像的3D本伯恩斯效果

https://arxiv.org/abs/1909.05483

还有一件事……

关于本伯恩斯效应,还有一个关于乔布斯的故事。

为了在苹果公司使用这种特效,乔布斯还专程联系了本伯恩斯,希望得到他的许可。

起初,伯恩斯拒绝了。他不想自己的名字被商业化。

然而,后来伯恩斯透露,他同意了乔布斯的要求。

中间发生了什么,并没有多少信息被传递出去。

现在,这种效果在iPhone中被广泛使用。比如照片的“回忆”功能,可以自动利用这种特效,把照片做成视频。

这也给伯恩斯带来了不少“麻烦”。

他说,有时候他走在街上,陌生人会冲向他,告诉他如何在iPhone上使用,或者问他问题。

在这种情况下,他说他尽力快速逃离现场。就像明星遇到盯梢粉丝。

emmm……

—结束—

编辑:王静

校对:林一林